CleverTarget

Для какой соцсети: ВКонтакте

Какие возможности предоставляет CleverTarget:

- Поиск аудитории: пожалуй, самая ожидаемая функция парсера. Поиск осуществляется по различным критериям.

- Управление: благодаря этому функционалу вы можете отслеживать новые комментарии и сообщения в группах ВКонтакте, не заходя в социальную сеть.

- Облачное решение: чтобы собирать аудиторию, необязательно быть онлайн, вы можете делать это в автономном режиме. Кроме того, все данные и отчёты хранятся в облаке, что позволяет возвращаться к ним в любое удобное время.

- Создание объявлений: если парсеры, которые были описаны выше, могли только находить аудиторию, то этот сервис позволяет в том числе создавать объявления.

Отдельная опция — прогнозирование ставок для размещения объявления с помощью искусственного интеллекта. Также парсер представляет инструмент для анализа конкурентов: оценивает активность в их сообществах, качество аудитории и т.д.

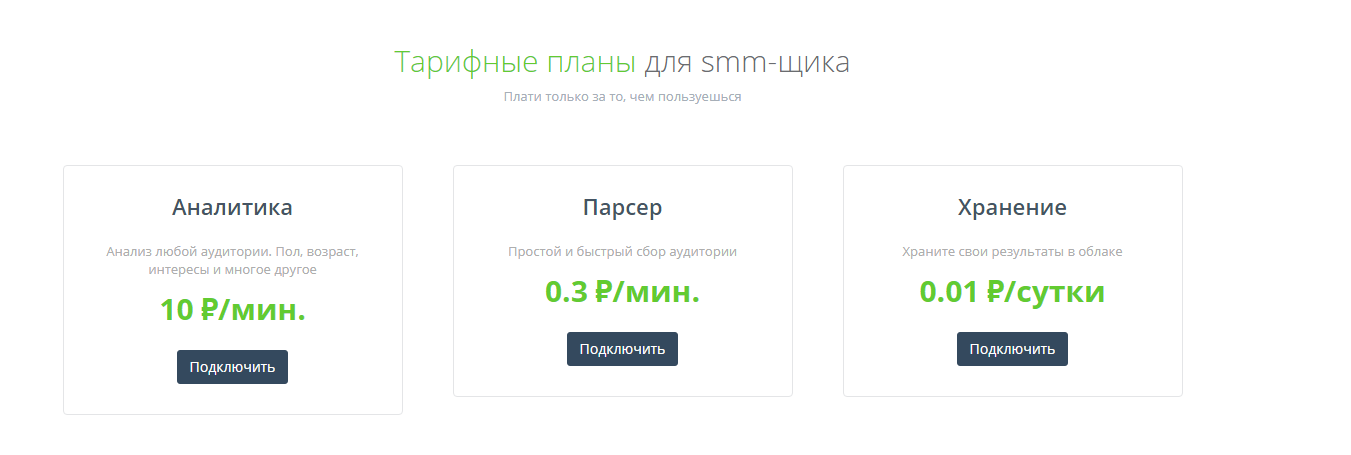

Стоимость: оплата посекундная — вы платите только за время работы в сервисе. Есть пробный период.

Оксана Михалко, руководитель группы digital-стратегов Ingate

Прежде чем приступать к парсингу пользователей, вы должны чётко определить, кто ваша целевая аудитория. Это существенно упростит работу, так как для каждого типа потенциального клиента вы сможете задать свои настройки таргетинга. В результате вероятность того, что реклама покажется тем пользователям, которые в ней действительно заинтересованы, повышается в разы. Как следствие, конверсия тоже будет выше. Собранную базу пользователей также можно использовать для настройки ретаргетинга в соцсетях.

Парсер ссылок. Кому и зачем нужны парсеры сайтов

Парсеры экономят время на сбор большого объема данных и группировку их в нужный вид. Такими сервисами пользуются интернет-маркетологи, вебмастера, SEO-специалисты, сотрудники отделов продаж.

Парсеры могут выполнять следующие задачи:

Кому и для каких целей требуются парсеры, разобрались. Если вам нужен этот инструмент, есть несколько способов его заполучить.

- При наличии программистов в штате проще всего поставить им задачу сделать парсер под нужные цели. Так вы получите гибкие настройки и оперативную техподдержку. Самые популярные языки для создания парсеров — PHP и Python.

- Воспользоваться бесплатным или платным облачным сервисом.

- Установить подходящую по функционалу программу.

- Обратиться в компанию, которая разработает инструмент под ваши нужды (ожидаемо самый дорогой вариант).

С первым и последним вариантом все понятно. Но выбор из готовых решений может занять немало времени. Мы упростили эту задачу и сделали обзор инструментов.

Как парсить тематические сообщества

Можно использовать парсер Pepper.Ninja, чтобы быстро найти группы по интересующей тематике и собрать аудиторию для настройки рекламы ВКонтакте.

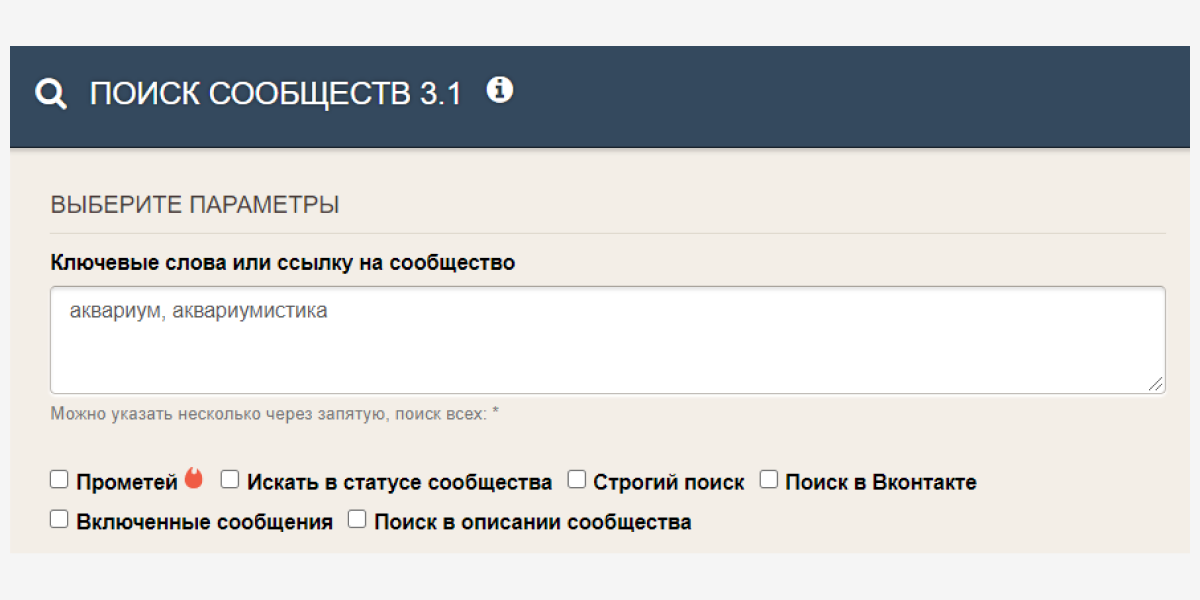

В инструменте «Поиск сообществ 3.1» можно указывать ключевые слова, встречающиеся в названии групп, и задавать параметры участников сообществ.

Парсинг ЦА во ВКонтакте выдаст список сообществ с информацией о количестве участников и сегментах сообщества

Парсинг ЦА во ВКонтакте выдаст список сообществ с информацией о количестве участников и сегментах сообщества

Например, вам надо найти людей, занимающихся аквариумистикой, и настроить на них рекламу. Самый простой способ сделать это – написать через запятую ключевые слова, которые могут содержаться в названии групп по вашей тематике (здесь можно указать и фразу целиком, например, «аквариум и рыбки»). Поиск автоматически учитывает разные варианты слова, поэтому достаточно указать ключ «аквариум» и не указывать производные «аквариумы», «аквариумов» и т. д.

Сразу под полем для ключевых слов можно применить дополнительные опции поиска. Например, найти группы, которые указали один из ключей в статусе или описании сообществ. Этот способ поможет найти еще больше тематических групп для дальнейшего сбора аудитории из них.

Лучшие программы для парсинга данных в 2022 году. Цели парсинга

1. Сбор данных для исследования рынка. Веб-сервисы извлечения данных помогут следить за ситуацией в том направлении, куда будет стремиться компания или отрасль в следующие шесть месяцев, обеспечивая мощный фундамент для исследования рынка. Программное обеспечение парсинга способно получать данные от множества провайдеров, специализирующихся на аналитике данных и у фирм по исследованию рынка, и затем сводить эту информацию в одно место для референции и анализа.

2. Извлечение контактной информации. Инструменты парсинга можно использовать, чтобы собирать и систематизировать такие данные, как почтовые адреса, контактную информацию с различных сайтов и социальных сетей. Это позволяет составлять удобные списки контактов и всей сопутствующей информации для бизнеса – данные о клиентах, поставщиках или производителях.

3. Решения по загрузке с StackOverflow. С инструментами парсинга сайтов можно создавать решения для оффлайнового использования и хранения, собрав данные с большого количества веб-ресурсов (включая StackOverflow). Таким образом можно избежать зависимости от активных интернет соединений, так как данные будут доступны независимо от того, есть ли возможность подключиться к интернету.

4. Поиск работы или сотрудников. Для работодателя, который активно ищет кандидатов для работы в своей компании, или для соискателя, который ищет определенную должность, инструменты парсинга тоже станут незаменимы: с их помощью можно настроить выборку данных на основе различных прилагаемых фильтров и эффективно получать информацию, без рутинного ручного поиска.

5. Отслеживание цен в разных магазинах. Такие сервисы будут полезны и для тех, кто активно пользуется услугами онлайн-шоппинга, отслеживает цены на продукты, ищет вещи в нескольких магазинах сразу.

В обзор ниже не попал наш сервис парсинга сайтов и последующего мониторинга цен, который в основном ориентирован на так называемый full-site web scraping (парсинг всего сайта). В отличии от инструментов ниже мы просто ежедневно отдаем «слепок» сайта в формате CSV/Excel для последующего анализа (ассортимент и цены), а инструменты ниже требуют некоторых усилий и подойдут для тех, кто готов «поработать руками» и кому нужна гибкость в парсинге.

Сервисы для анализа целевой аудитории. Анализ продвижения в соцсетях

Один из самых популярных сервисов для анализа рекламы конкурентов в соцсетях. Помогает найти рекламные объявления и публикации по определенным ключевым словам или посмотреть все объявления конкретного конкурента (по ID или названию профиля).

С помощью сервиса вы сможете проанализировать креативы конкурентов и использовать лучшие решения при подготовке своих рекламных публикаций.

18. Rival IQ

Стоимость: от 199$/месяц.

автоматическое отслеживание активности конкурентов. Сервис пришлет уведомление, если конкурент изменит описание своего профиля или опубликует новый пост;

определение продвигаемых публикаций;

популярные темы и тренды. Можно отслеживать, какие темы пользуются большим спросом, кто из конкурентов публикует посты этой темы и какой охват они получают.

19. ADSpoiler

Стоимость: есть два тарифных плана: 600 и 1500 руб/месяц.

Сервис аналитики рекламы и групп ВКонтакте. В сервисе много полезных функций:

поиск групп, которые активно продвигаются через таргет;

база рекламных креативов — более 20 млн публикаций, по которым доступна детальная статистика: количество вступивших по часам, стоимость одной подписки, демография, охват, бюджет, активность под постом и т. д.;

анализ аудитории подписчиков;

история продвижения и посты группы.

Если вы активно продвигаетесь в соцсетях, то рекомендуем посмотреть нашу подборку 30+ парсеров для поиска целевой аудитории, мониторинга упоминаний бренда и анализа конкурентов в ВК, ФБ и Одноклассниках.

20. ADLover

Стоимость: 1500 руб/месяц. Познакомиться с основными функциями можно в бесплатном демо-режиме.

Русскоязычный сервис для анализа рекламных креативов в Facebook и Instagram. Must-have сервис для всех, кто продвигается в этих соцсетях.

Возможности:

поиск рекламных объявлений из Stories и лент. Можно найти объявления определенного рекламодателя (с помощью фильтра по юзернейму);

детальная информация по креативам: длительность показа, реакции на контент;

возможность скачивать

детальная статистика по русскоязычным профилям: график динамики и активности, история продвижения, аналитические метрики.

21. ADheart

Стоимость: 3 000 руб/месяц. Есть бесплатный демо-режим с ограниченным функционалом.

Сервис с огромной базой рекламных объявлений в Facebook и Instagram. Возможности:

поиск по базе из 400+ млн объявлений с помощью фильтров;

просмотр статистики по объявлениям (дата запуска, длительность открутки);

поиск всех объявлений из одной страницы ФБ /домена/IP.

Стоимость: бесплатно.

Бесплатный инструмент от Facebook, который позволяет посмотреть все активные объявления таргетированной рекламы конкурентов. Для этого нужно ввести название или id страницы конкурента, и сервис покажет все запущенные объявления.

Сайты для тренировки парсинга. Часть 1

Анализ данных предполагает, в первую очередь, наличие этих данных. Первая часть доклада рассказывает о том, что делать, если у вас не имеется готового/стандартного датасета, либо он не соответствует тому, каким должен быть. Наиболее очевидный вариант — скачать данные из интернета. Это можно сделать множеством способов, начиная с сохранения html-страницы и заканчивая Event loop (моделью событийного цикла). Последний основан на параллелизме в JavaScript, что позволяет значительно повысить производительность. В парсинге event loop реализуется с помощью технологии AJAX, утилит вроде Scrapy или любого асинхронного фреймворка.

Извлечение данных из html связано с обходом дерева, который может осуществляться с применением различных техник и технологий. В докладе рассматриваются три «языка» обхода дерева: CSS-селекторы, XPath и DSL. Первые два состоят в довольно тесном родстве и выигрывают за счет своей универсальности и широкой сфере применения. DSL (предметно-ориентированный язык, domain-specific language) для парсинга существует довольно много, и хороши они, в первую очередь, тем, что удобство работы с ним осуществляется благодаря поддержке IDE и валидации со стороны языка программирования.

Для тренировки написания пауков компанией ScrapingHub создан учебный сайт toscrape.com , на примере которого рассматривается парсинг книжного сайта. С помощью chrome-расширения SelectorGadget , которое позволяет генерировать CSS-селекторы, выделяя элементы на странице, можно облегчить написание скрапера.

Пример с использованием scrapy :

Пример без scrapy:

Законно ли использовать парсинг

После выяснения что такое парсинг, может показаться, что это нечто, не соответствующее нормам действующего законодательства. На самом деле это не так. Законом не преследуется парсинг. Зато запрещены:

- взлом сайта (то есть получение данных личных кабинетов пользователей и т. п.);

- DDOS-атаки (если на сайт в результате парсинга данных ложится слишком высокая нагрузка);

- заимствование авторского контента (фотографии с копирайтами, уникальные тексты, подлинность которых заверена у нотариуса и т. п. лучше оставить на их законном месте).

Парсинг законен, если он касается сбора информации, находящейся в открытом доступе. То есть всего, что можно и так собрать вручную.

Парсеры просто позволяют ускорить процесс и избежать ошибок из-за человеческого фактора. Поэтому «незаконности» в процесс они не добавляют.

Другое дело, как владелец свежесобранной базы распорядится подобной информацией. Ответственность может наступить именно за последующие действия.

Находим упущенные ключевые слова

Собрать все ключи и объявления конкурентов полезно для общего анализа и понимания ситуации

Но если у вас уже запущены рекламные кампании, важно понимать другое: какие слова используют ваши конкуренты, а вы – нет

Как это сделать

1. Подготовьте список ключевых слов, по которым у вас запущена реклама.

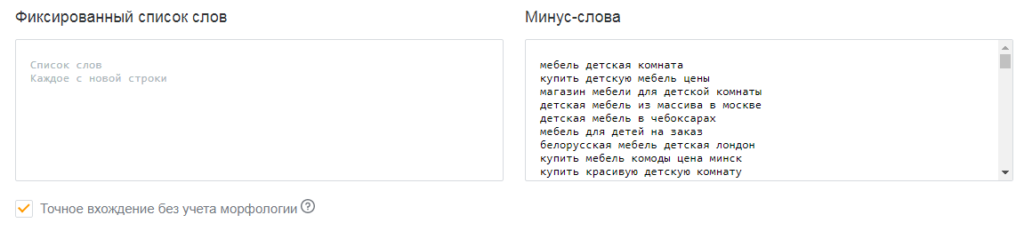

2. Перейдите в инструмент «Слова и объявления конкурентов». Укажите домены конкурентов (которые хотите спарсить). В блоке профессиональных настроек вставьте ключи в поле «Минус-слова».

Все слова, добавленные в поле «Минус-слова», система исключит при парсинге. В результатах будут только те ключи, которые вы еще не использовали.

Важно! В блоке профессиональных настроек парсера также есть опция «Точное вхождение без учета морфологии». Если она включена, система не будет собирать указанные ключи в базовом виде, а также с изменением падежа

3. Запустите парсинг и скачайте результаты. На выходе вы получите готовый набор ключей, с помощью которого можете расширить семантику.

Ничто не вечно

И ваш парсер тоже. Вы можете читать этот материал через день или через год после выхода. На момент подготовки статьи сайт Skillbox Media выводил по семь статей на странице: одну в закрепе и шесть снизу. Впоследствии разработчики неожиданно удвоили выдачу — теперь уже выводится по 14 статей в следующем порядке: одна в закрепе, шесть снизу, снова одна в закрепе и ещё шесть снизу.

Мы решили оставить этот факт как часть урока о парсерах: сайт, который вы собираете, может в любой момент поменять дизайн и структуру материалов, поэтому не следует ожидать, что ваш сборщик будет работать вечно даже на одном и том же ресурсе.

В ходе теста выяснилось, что с выдачей 14 материалов вместо семи указанный выше код также справляется, поскольку параметры с номером страницы и количеством статей на ней взаимосвязаны и ответ сервера адаптируется под ваш запрос (даже если он построен по старому принципу).

Быстрый парсинг всех ключевых слов и объявлений для указанных доменов

Создайте аккаунт в системе PromoPult (или авторизуйтесь, если у вас уже есть аккаунт). Откройте инструмент «Слова и объявления конкурентов». В блоке «Добавить задачу» укажите домены конкурентов или загрузите их с помощью XLSX-файла.

Блок профессиональных настроек пока не трогаем (мы еще разберем его).

В блоке «Поисковые системы» можно выбрать, в какой поисковой системе проверять домены. По умолчанию это Яндекс и Google. Также по умолчанию стоит галочка на пункте «Результаты на едином листе XLS» – в таблице с результатами данные по всем доменам будут сведены на одном листе.

Если вы проверяете небольшое количество доменов (до 5), можете ничего не менять здесь. Если же доменов больше, уберите галочку с этого пункта. В результатах парсинга под каждый домен будет создан отдельный лист – это удобнее для анализа большого количества данных.

Жмем «Запустить проверку». Система начнет парсинг доменов (в нашем случае на это ушло 5 минут). Если у вас нет времени ждать, вы можете закрыть страницу с инструментом – все работы проводятся в фоновом режиме.

После окончания проверки вам на почту придет уведомление:

Раскройте блок «Список задач» и кликните по пиктограмме Excel-таблицы, чтобы скачать отчет. Также здесь можно удалить отчет или запустить повторный парсинг.

В настройках парсинга есть возможность выбрать отображение отчета: отдельный лист для каждого домена или все на одном листе.

В зависимости от этой настройки отчет будет выглядеть по-разному.

Отчет по каждому домену на разных листах

В нашем примере мы получили именно такой отчет. При скачивании загружается архив с файлами в формате CSV:

Что содержит архив:

Файл с уникальными ключевиками для всех конкурентов. Для пяти доменов, которые мы добавляли в проверку, парсер собрал почти 32 000 ключей.

Общие результаты – данные по количеству объявлений на поиске Google и Яндекс. Для каждого домена данные указаны в разрезе регионов.

Технический файл, в котором указаны настройки парсинга.

Файлы с названиями доменов. Содержат ключевые слова конкурентов, заголовки и тексты объявлений. Данные указаны в разрезе поисковых систем и регионов. Например, вы можете посмотреть, какие объявления показывает конкурент в Яндексе в Санкт-Петербурге.

Обратите внимание! При парсинге объявления собираются из результатов поисковой выдачи в таком виде, в котором они отображаются. Кроме основного текста и заголовка могут собираться уточнения, быстрые ссылки и другие расширения (если они есть в объявлении)

Данные по доменам на одном листе

При таком способе отображения отчета загружается один XLSX-файл с четырьмя листами. Даже если вы парсите 50 доменов, листов в файле все равно будет четыре. Какие это листы:

«Результаты общие» – количество уникальных объявлений по всем доменам. Данные указаны в разрезе регионов и поисковых систем.

- «Слова и объявления». На этом листе собрана семантика по всем конкурентам и тексты объявлений. Данные указаны по каждому региону и поисковой системе. Если доменов много, работать с такой таблицей будет неудобно.

- «Слова». Собраны уникальные ключевики по всем доменам.

- «Исх. настройки». Указаны настройки парсинга.

Церебро Таргет

Для какой соцсети: ВКонтакте

Церебро Таргет — это инструмент для сбора и сегментации нужной аудитории ВКонтакте. Например, вы хотите найти, в каких группах состоят ваши подписчики. Для этого достаточно вставить ссылку на ваше сообщество в поисковую строку, и вы получите список групп. Благодаря этому можно настраивать рекламу на паблики, заранее зная, что в них есть ваша аудитория.

Какие возможности предоставляет Церебро Таргет:

- «Поиск аудитории»: позволяет находить другие паблики (помимо вашего собственного), в которых состоят ваши подписчики.

- «Аудитория сообщества»: позволяет собирать базу сообществ, в которых состоит интересная вам аудитория. Например, вы ищете группы, в которых основная ЦА — женщины 25–35 лет.

- «Фильтр базы»: позволяет разделить на категории собранные вами сегменты. Например, из полученной базы пользователей вы можете выбрать только тех, кто женат или замужем.

- «Пересечение аудитории»: позволяет исключить из сегмента пользователей, которые состоят, например, в нескольких сообществах.

Стоимость: зависит от выбранного функционала. Вы также можете указать период оплаты, вплоть до одного дня, если хотите протестировать инструмент.

Оффлайн парсеры

Возможность парсинга Яндекс Вордстат без доступа к интернету или при его низкой скорости – одно из требований к современным инструментам СЕО анализа. Технически это реализовано просто – на компьютер или аналогичное устройство, скачивается базы Wordstat и затем с помощью программы происходит выборка ключевых слов.

Букварикс десктопная версия

Впервые полноценный десктопный вариант представили разработчики «Букварикс». Однако уже в октябре 2017 года этот проект был «заморожен», ПО и базы данных не обновляются. Компания предлагает все инструменты в онлайн-режиме. Скачать приложение можно на старой версии официального сайта, использование бесплатное.

Что нужно учитывать при использовании десктопной версии:

- скачиваемый объем – около 30 Гбайт;

- скачать можно только с Яндекс.Диска, состоит из 20 частей;

- последняя дата обновления БД – 1 октября 2017 г.

Информация в этой версии устарела, возможно использование как вспомогательного инструмента.

Парсинг участников чата через бота

Кроме сервисов, работающих через браузер и с персонального компьютера, существуют боты. Таких много, но их список постоянно меняется.

Telecobra

Этот бот имеет отношение к тому же разработчику, что и одноименная программа. Работать в нем нужно так:

- Запустить программу.

- Выбрать нужное действие.

- Указать требуемый параметр.

- Получить файлы с результатом.

В боте есть разные предложения по парсингу чатов. В зависимости от выбора, будет соответствующий результат.

Parsetgbot

Этот бот предназначен для парсинга Телеграм чатов. Есть бесплатный функционал и расширенный. Общая инструкция:

- Запустить бота кнопкой «Старт».

- Выбрать нужную услугу в меню.

- Дать ссылку на группу.

- Скачать файлы с результатом.

Спарсить аккаунты в Телеграме несложно. Достаточно воспользоваться подходящими сервисами в виде программ или ботов. Некоторые из них дают еще и возможность посмотреть подписчиков в канале Телеграм, но только в расширенной версии.

4 лучших онлайн парсера для Телеграм каналов

Выбирать парсер чатов Телеграм среди онлайн сервисов можно по разным критериям. Большинство из них имеют расширенный функционал и могут осуществлять дополнительные действия – своеобразные комбайны по рекламной работе в ТГ.

Telegram Soft

Разработчики позиционируют этот сервис как удобный инструмент для продвижения в Телеграм. Из предлагаемого функционала:

- сбор @username участников чата;

- фильтрация по активности и последнему входу;

- рассылка сообщений и приглашений.

Существует услуга парсинга закрытых групп, а готовую базу можно выгрузить в *.txt. Инструкция для работы с открытыми чатами:

- Заранее подготовить список тематических чатов со свободным доступом.

- Открыть окно программы Telegram Soft.

- Слева, в разделе «Парсер», есть окно для вписывания адресов в виде @username или https://t.me/username.

- Справа расположено окно фильтра, где можно выставить параметры отсева.

- Есть второй раздел фильтра, помогающий отсеять по активности в группе (программа проверит N последних СМС).

- После выставления фильтра нажать на кнопку «Начать».

- В окне «Вывод» будет отображаться лог работы программы.

- По завершении работы парсера надо кликнуть по кнопке «Сохранить результат (N)».

- Результат в сохраненном виде выглядит как список @username необходимой аудитории.

Полезно: Подборка лучших Телеграм каналов и ботов с бесплатными книгами

Telecobra

Этот сервис выполнен в виде программы, работающей под ОС Windows XP, Vista, 7, 8, 10. Парсинг в настроенном приложении проходит таким образом:

- Выбрать ТГ-канал или чат, с которого нужно получить список.

- Вставить ссылку или несколько в строку «Доноры».

- Задать, какие данные нужны.

- Определить, какой тип пользователей.

- Обозначить вариант сбора аудитории в чекбоксе.

- Указать формат сохранения списка пользователей.

- Кликнуть по кнопке «Добавить задачу и начать сбор».

- Подтвердить использование сессии или настроить новую.

- Откроется лог работы.

- По завершении работы парсера отыскать готовый список можно в папке «Parser».

- Файл будет помечен как «Сбор».

Telereg

Данный сервис был создан в качестве дополнительного скрипта на zennolab, чтобы автоматически регистрировать профиль. Но в платную версию, в числе прочих, добавлена функция парсера. Сейчас этот проект существует отдельно. Инструкция по парсингу такая:

- Открыть раздел «Парсинг» в окне программы.

- Ввести мобильный номер аккаунта Телеграм.

- Выбрать формат для сохранения списка (по умолчанию *.txt).

- Запустить работу скрипта, нажав на кнопку «ОК».

A-Parser

Программа A-Parser представляет собой комбайн, рассчитанный на выполнение разных задач. В частности, через нее можно спарсить телефоны с группы в мессенджере Телеграм. Инструкция по общему парсингу:

- Выбрать GroupScraper в чекбоксе.

- Указать адрес группы.

- Подтвердить старт работы.

В результате пользователь получит полный отчет по переписке за последний период. Будут сообщения и @username подписчиков. Есть дополнительные настройки.

Как устроен парсинг сайтов

Вкратце процедуру сбора данных с сайта можно описать следующим образом:

- Определяем сайт-источник и желаемые данные.

- Выясняем способ пагинации (перехода по страницам) и структуру кода сайта.

- Любым из множества возможных способов делаем последовательные сетевые запросы по каждой странице. Если у сайта есть API — используем API, если нет — другие инструменты.

- Переводим полученные данные в удобный формат.

- Записываем итоговые данные в файл.

Успех зависит от правильного анализа сайта. Нам нужно будет выяснить:

- Как происходит переход на следующую страницу. Это нужно, чтобы парсер делал всё автоматически, — в противном случае сбор завершится на первой же странице. Обычно это происходит при нажатии кнопки типа «Далее» или «Следующая страница» — а парсер имитирует нажатие.

- Правильное и точное место, где в HTML-разметке сайта содержатся нужные материалы. Для этого придётся определить местонахождение (вложенность) блоков, а также их селекторы.

Запросы нужно делать «вежливо», то есть с некоторой задержкой, чтобы не навредить сайту-источнику (например, не очень хорошо запускать цикл из сотни мгновенных запросов сразу ко всем страницам архива).

И категорически запрещено нарушать авторские права. Перед разработкой парсера стоит ознакомиться с пользовательским соглашением, которое может прямо запрещать автоматический сбор данных.

Заключение

Мы рассмотрели два рабочих способа автоматического сбора материалов на сайтах СМИ. Есть и другие варианты: парсить список материалов в Excel-таблицу, в файл закладок для импорта в браузер, сделать красивый дизайн, автоматически отправлять результат в Telegram-чат через бота, сортировать, проводить контент-анализ (рубрики, ключевые слова, частота публикации), вставлять галочки для отметки прочитанного и так далее — насколько хватит фантазии.

Вероятно, приведённый выше код не идеален, ведь он написан не профессиональным программистом, а журналистом, применяющим программирование в работе. Это важный момент: он показывает, что сейчас программирование нужно всем и доступно всем, если выйти за пределы привычных методов работы и изучить что-то новое.